Studierende der FHWS gewinnt Best-Paper-Award auf der Konferenz Advances in Computer-Human Interactions (ACHI 2020)

Face-to-Face Gesprächssituationen nutzen eine Vielzahl von Kommunikationskanälen. Allerdings kann nicht jeder eine Gesprächssituation auf allen diesen Kanälen wahrnehmen. Menschen mit einer Beeinträchtigung bei der Erkennung, bspw. der Sehkraft, stehen nicht alle nonverbale Informationen zur Verfügung. Dies kann u.U. dazu führen, dass eine Person mit beeinträchtigter Erkennung eine Kommunikationssituation nur eingeschränkt analysieren kann.

An einer Lösung für dieses Problem wird aktuell an der Professur für Sozioinformatik der Hochschule Würzburg-Schweinfurt gearbeitet. Ein Work in Progress Paper zu diesem Thema wurde zur Konferenz Advances in Computer-Human Interactions (ACHI 2020) eingereicht. Die ACHI 2020 ist die 13. Internationale Konferenz über Fortschritte in der Mensch-Computer Interaktion. Anna Kushnir studiert im Master Informationssysteme an der Fakultät für Informatik und Wirtschaftsinformatik der FHWS und wurde für ihr Projekt an der Forschungsprofessur Sozioinformatik mit dem Best-Paper-Award in der Kategorie „Interfaces“ ausgezeichnet.

In ihrem Forschungsbeitrag mit dem Titel „Development of a Wearable Vision Substitution Prototype for Blind and Visually Impaired That Assists in Everyday Conversations” beschreibt sie das Ziel der prototypischen Entwicklung einer Substitutionslösung für Menschen mit Beeinträchtigung bei der Erkennung visueller Informationen, um dadurch Alltagsgesprächssituationen zu unterstützen. In dem Beitrag werden die Idee und die laufenden Arbeiten an der Substitutionslösung beschrieben, welche visuelle Reize mithilfe des Facial Action Coding System (FACS) in taktile Reize umwandelt und somit für den Nutzer wahrnehmbar macht. Hintergrund der Idee ist, dass bereits verbreitete Substitutionslösungen für Menschen mit einem beeinträchtigten Sehsinn meistens audiobasiertes Feedback nutzen. Derartige Lösungen unterstützen in den verschiedensten Lebenssituationen, allerdings eignen sie sich nicht für die Unterstützung der Kommunikation. Der Grund dafür ist, dass das audiobasierte Feedback sich mit der verbalen Kommunikation vermischen kann und so von ihr ablenken würde.

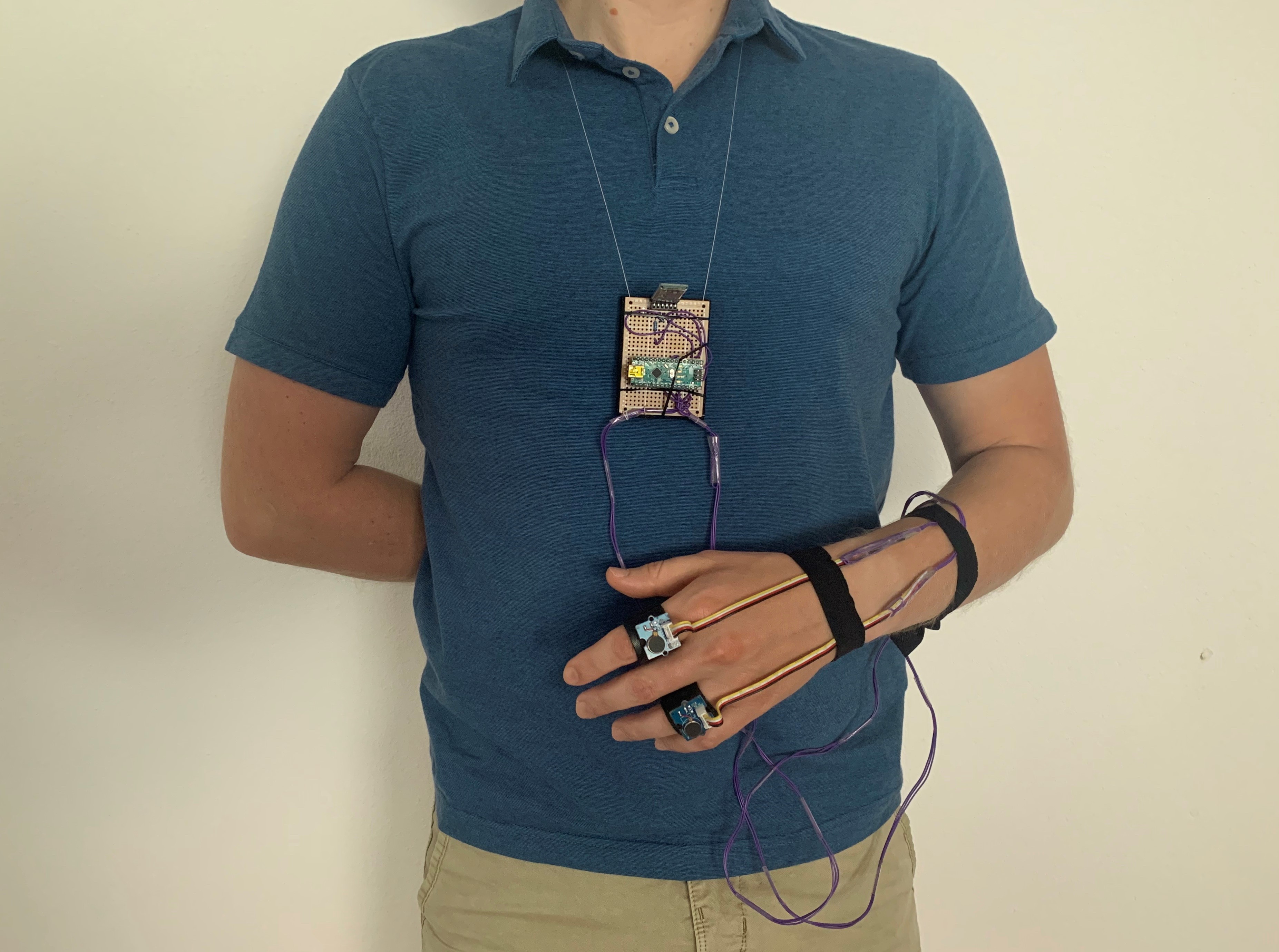

Die von Anna Kushnir entwickelte Substitutionslösung, setzt deshalb auf taktiles Feedback. Der Stand des Prototyps zum Zeitpunkt der Erstellung des Papers ist in Abbildung 1 (unten links) zu sehen. Die Aufgabe des Systems ist es, die emotionale Valenz, die an der Mimik des Gesprächspartners erkannt werden kann, in taktile Reize umzuwandeln und somit für den Nutzer mit einer Einschränkung wahrnehmbar zu machen. Für das taktile Interface wurden Vibrationsringe eingesetzt, welche an den Fingern getragen werden. Zur Analyse und Klassifikation der Gesichtsmuskelaktivitäten wird die FACS-gestützte Gesichtsausdrucksanalysesoftware Facereader von Noldus verwendet.

Derzeit wird der Prototyp im Rahmen einer Masterarbeit um weitere Funktionalitäten erweitert und wird anschließend mithilfe einer qualitativen Studie evaluiert werden. Abbildung 2 (unten rechts) zeigt den aktuellen Stand des Prototyps, der auch im Rahmen der FutureCode Konferenz in Würzburg vorgestellt wurde. Um dem Nutzer noch detailliertere Informationen über die Gesprächssituation mitzuteilen, wird aktuell daran gearbeitet, den Prototyp um die sieben Basisemotionen nach Ekman zu erweitern.